Az elmúlt évtizedek legnagyobb szivárgása betekintést enged a Google keresőmotorjának féltve őrzött titkaiba

Két hét telt el azóta, hogy a Google egy nappal az OpenAI hasonló bejelentése után bemutatta, hogy mennyire turbózta fel a saját, mesterséges intelligenciára épülő platformját, a Geminit (spoiler: eléggé). Ekkor mutatták meg egyebek mellett a keresőmotorjukba épített verziót is, amely AI Overviews néven fut, és nagyjából azt csinálja, amit a Bing már hónapok óta tud: ír egy rövid összefoglalót a keresési eredmények fölött arról, amire rákerestünk. Az elmúlt hét alapján ez az egész viszont nem sült el annyira jól.

A mesterséges intelligencia (MI) azt tanácsolta az embereknek, hogy tegyenek ragasztót a pizzaszószba, hogy ne csússzon le róla a sajt – ezt a Yahoo újságírója ki is próbálta, remek olvasmány –, rakjanak gázolajat a spagettibe, és egyenek naponta legalább egy követ. A pizzaszószos tanács amúgy egy fucksmith nevű redditező 11 éves kommentjéből származik, a köves pedig az Onion nevű szatirikus oldalról. A Google állította, hogy ezek extrém esetek, de manuálisan elkezdte törölgetni a rizikósabb dolgokat,

időközben azonban egy sokkal nagyobb problémával kell szembenézniük, miután több ezer oldalnyi, a keresőmotorjuk működésébe betekintést engedő belsős dokumentáció szivárgott ki tőlük.

A szivárgásról egy Rand Fishkin nevű egykori SEO-, azaz keresőoptimalizálási specialista számolt be hétfőn egy terjedelmes blogposztban, és nem is kell nagyon beleásni magunkat ebbe ahhoz, hogy kiderüljön, a dokumentumok egy rakás dologban ellentmondanak a Google korábbi, a keresőmotorjuk működéséről kiadott hivatalos közleményeinek. Fishkint a posztja szerint május 5-én kereste meg a szivárogtató, hogy hozzáfért a keresésért felelős divízió több mint 2500 oldalnyi belsős API-dokumentációjához, melyek hitelességét volt Google-alkalmazottak is megerősítették. (Az API vagy magyarul alkalmazásprogramozási felület leegyszerűsítve a szoftverek egymás közti kommunikációját teszi lehetővé.)

A forrás időközben névvel is előállt, Erfan Aziminek hívják, és nem meglepő, hogy nyilvánosságra akarta hozni a dokumentumokat, mert ő maga is SEO-ban utazik, az EA Eagle Digital nevű cég alapítójaként lehet ismerni. Azimi múlt pénteken mutatta be Fishkinnek a dokumentumokat, amelyek idén március végén, alighanem véletlenül váltak nyilvánosan elérhetővé a kódmegosztásra használt GitHubon, és egészen május 7-ig hozzáférhetőek is maradtak. Ilyen dokumentációk a Google összes csapatánál léteznek, konyhanyelven az a funkciójuk, hogy a dolgozók tudják, pontosan mi áll rendelkezésükre, és hol találják azt.

Fishkin ezután több ex-google-ös ismerősét is megkérdezte a szivárgásról, akiktől a dokumentumok átnyálazása után azt a választ kapta, hogy ezek megegyeznek a Google általuk is látott belsős dokumentációival, és semmi nem utal arra, hogy kamuról lenne szó. Ezután kereste meg az iPullRank nevű ügynökséget alapító Mike Kinget, aki vele ellentétben jelenleg is SEO-val foglalkozik, és az egyik legnagyobb szaktekintélynek számít a szakmában, King pedig szintén arra jutott, hogy a szivárgás hiteles, és rengeteg olyan információt tartalmaz, amelyet eddig csak sejteni lehetett.

Így elemezni is abszolút volt értelme a dokumentumokat, és ezt nemcsak Fishkin tette meg, hanem King is, aki itt publikálta az elemzését, és mint írta, több mint valószínű, hogy ezt több másik bejegyzés fogja követni, mert tényleg rengeteg adatról van szó. Mielőtt rátérnénk a konkrétumokra, Fishkin nyomán érdemes leszögezni, hogy nem lehet megmondani, hogy ez a legfrissebb dokumentáció-e, illetve hogy pontosan mely funkciók azok, amelyeket mondjuk csak tesztelésre használtak vagy akár egyáltalán nem is vetettek be.

Emiatt nem is igazán lehet kiemelni egyes részeit és ezek alapján mutogatni bizonyos funkciókra, de az is biztos, hogy Fishkin szerint még így is ez a legjelentősebb bizonyíték a Google évek óta húzódó trösztellenes perében nyilvánosságra került információk óta.

King a saját posztjában azt is kiemelte, hogy a per korábbi meghallgatásain elhangzottak jelentős részét meg is erősítik a dokumentumok. Ez kétségtelenül elég izgalmas, hiszen a Google keresőmotorjának működése hétpecsétes titok, ezért is lett akkora biznisz a keresőoptimalizálásból. Egy idén megjelent tanulmány szerint mostanra teljesen tönkre is tette a keresési élményt, hogy a Google rendszerét kihasználó SEO-mágusok miatt egyre több a tökéletesen optimalizált, de tartalmilag alacsony minőségű tartalom a találatok között. A Google persze szereti hangoztatni, hogy ez nem a rendszer nyomásgyakorlása miatt van így, a kiszivárgott dokumentumokban viszont elég sok dolog utal arra, hogy márpedig de.

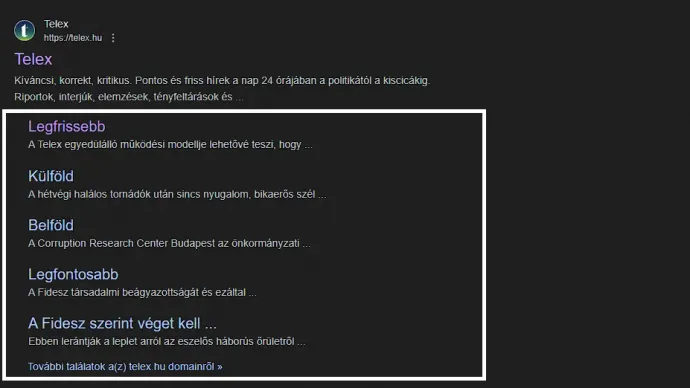

Fishkin és King is kigyűjtöttek néhány ilyet a saját írásaikban, de a legfontosabb ezek közül talán az, hogy az eddigi állításokkal ellentétben a jelek szerint igenis használják a Chrome-ból szedett adatokat a keresési eredmények sorba állításához. Amikor rákeresünk egy weboldalra, akkor nemcsak magát a honlapot dobja fel a kereső, hanem alatta bizonyos aloldalakat is külön kattinthatóvá tesz, a dokumentáció alapján pedig ezeket részben a Chrome-ból gyűjtött kattintási adatok alapján rendezi sorba. Alább egy példa, hogy mire gondolunk, és ez pontosan hogy néz ki:

Az is valószínűnek tűnik, hogy bár korábban ennek ellenkezőjét állították, valójában ők is mérik a weboldalak keresőben való megjelenését befolyásoló hitelességét (ezt a szakmában domain authoritynek nevezik), valamint hogy a rangsorolásnál figyelembe veszik a keresések közben végrehajtott kattintásokat, illetve azt, hogy ezek után mi történt (maradt-e a felhasználó az oldalon, vagy egyből visszát nyomott). Arra vonatkozó információk is vannak, hogy a Google mégiscsak különböző homokozókba válogatja a weboldalakat az életkoruk vagy a megbízhatóságuk alapján, és az is valószínű, hogy a megosztó témáknál fehérlistára raknak általuk megbízhatónak tartott honlapokat.

Az is kiderült ugyanakkor, hogy az úgynevezett E-E-A-T keretrendszer – tapasztalat (Experience), szakértelem (Expertise), tekintély (Authoritativeness) és megbízhatóság (Trustworthiness) – kevésbé lehet fontos, mint amennyire sok keresőoptimalizálással foglalkozó szakember megpróbálja beállítani, legalábbis az alapján, hogy konkrétan nem igazán szerepelt a dokumentumokban. A befolyásos szereplőket természetesen észleli a Google, és előrébb is sorolhatja őket, de az nem világos, hogy a rendszerben pontosan mi tartozik ide, és Fishkin szerint rengetegen vannak, akik ezek nélkül is jól teljesítenek a keresőben.

Fishkin a bejegyzése végén azt írta, nagyon izgatott, hogy a következő időszakban mit fognak még kitúrni a dokumentumokból a szakmabeliek, és egyben oda is szúrt azoknak az iparági szereplőknek, akik az azokkal ellentétes bizonyítékok ellenére is bármiféle kritika nélkül megismétlik a Google tagadó közleményeit. Mint írta, ha ez a szivárgás és a tavalyi meghallgatás csak egy változást hoznak, reméli, hogy az ennek a gyakorlatnak vége lesz majd.

Rád is szükségünk van!

A Transtelex minden nap hiteles, ellenőrzött erdélyi történeteket hoz — sokszor több munkával, több kérdéssel és több utánajárással, mint mások. Ha fontos neked, hogy legyen független forrás, ahol a kényelmetlen kérdéseket is felteszik, kérjük, támogasd a munkánkat!

Támogatás