Nemzetközi vita kerekedett az Elon Musk által aláírt, a ChatGPT-kutatás szüneteltetését követelő levél miatt

Nagy vihart kavart az Elon Musk és több ezer szakértő által aláírt, a mesterséges intelligencia kutatásának szüneteltetését követelő levél, miután a levélben idézett kutatók elítélték munkájuk felhasználását, egyes aláírásokról kiderült, hogy hamisítványok, mások pedig visszaléptek a támogatástól.

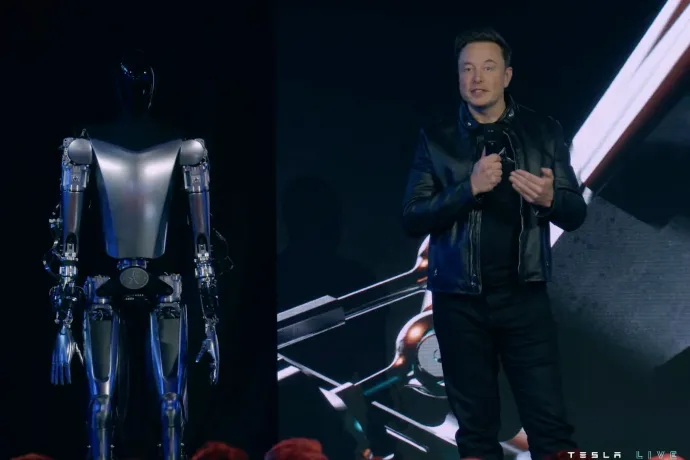

Elon Musk és mintegy 1000 mesterséges intelligencia szakértők, illetve vállalatvezetők egy csoportja a GPT-4-nél erősebb mesterséges intelligencia rendszerek kiképzésének hat hónapos szüneteltetését követelte. Erről egy nyílt levélben írtak a Reuters beszámolója szerint. A kérést a társadalomra és az emberiségre gyakorolt potenciális kockázatokra hivatkozva fogalmazták meg.

A nonprofit Future of Life Institute által kiadott levél, amelyet több mint 1000 ember, köztük Elon Musk, Steve Wozniak, az Apple társalapítója és Emad Mostaque, a Stability AI vezérigazgatója írt alá, a fejlett mesterséges intelligencia fejlesztésének szüneteltetésére szólít fel mindaddig, amíg az ilyen konstrukciók közös biztonsági protokolljait független szakértők nem dolgozzák ki, nem hajtják végre és nem ellenőrzik.

Az Amazon, a DeepMind, a Google, a Meta és a Microsoft mérnökei is támogatásukról biztosították a kezdeményezést.

A Musk által alapított és most a Microsoft által támogatott OpenAI által kifejlesztett GPT-4 képes emberhez hasonló beszélgetést folytatni, dalokat komponálni és hosszú dokumentumokat összefoglalni.

Az ilyen, „emberekkel versenyképes intelligenciával” rendelkező mesterséges intelligencia-rendszerek mélyreható kockázatot jelentenek az emberiségre nézve – állítja a levél.

„Az AI-laboroknak és a független szakértőknek ezt a szünetet arra kellene felhasználniuk, hogy közösen dolgozzanak ki és hajtsanak végre egy sor közös biztonsági protokollt a fejlett AI-tervezés és -fejlesztés számára, amelyeket független külső szakértők szigorúan ellenőriznek és felügyelnek” – áll a levélben.

Az erőfeszítéseket koordináló Future of Life Institute (Az élet jövője intézet) 12 szakértői tanulmányt idézett, amelyekben kutatók, egyetemi oktatók, valamint az OpenAI, a Google és leányvállalata, a DeepMind jelenlegi és korábbi alkalmazottai vettek részt. Négy, a levélben idézett szakértő azonban aggodalmát fejezte ki amiatt, hogy kutatásukat ilyen állítások megfogalmazására használták fel.

A Guardian arról ír, hogy amikor a levelet eredetileg elindították, nem voltak ellenőrzési protokollok az aláírásra, és olyan személyeknek is feltűnt a neve az aláírók között, akik valójában nem írták alá, köztük Hszi Csinping és a Meta vezető mesterséges intelligencia kutatója, Yann LeCun, aki a Twitteren tisztázta, hogy nem támogatja a levelet.

A kritikusok azzal vádolták az elsősorban a Musk Alapítvány által finanszírozott Future of Life Institute-ot (FLI), hogy az elképzelt apokaliptikus forgatókönyveket helyezi előtérbe a mesterséges intelligenciával kapcsolatos közvetlenebb aggodalmakkal szemben – például azzal, hogy rasszista vagy szexista előítéleteket programoznak a gépekbe.

Az idézett kutatások között szerepelt az „On the Dangers of Stochastic Parrots” című, jól ismert tanulmány, amelynek társszerzője Margaret Mitchell volt, aki korábban a Google etikai AI-kutatásait felügyelte. Mitchell, aki jelenleg a Hugging Face nevű mesterséges intelligenciával foglalkozó cég vezető etikai kutatója, bírálta a levelet, és a Reutersnek azt mondta, nem világos, hogy mi számít „erősebbnek a GPT4-nél”.

„Azzal, hogy a levél számos megkérdőjelezhető ötletet adottnak tekint, olyan prioritásokat és narratívát állít fel a mesterséges intelligenciáról, amely az FLI támogatóinak kedvez” – mondta. „Az aktív ártalmak figyelmen kívül hagyása jelenleg olyan kiváltság, amellyel néhányunk nem rendelkezik.”

Társszerzői, Timnit Gebru és Emily M Bender a Twitteren kritizálták a levelet, utóbbi a levél egyes állításait „meggondolatlannak” nevezte. Shiri Dori-Hacohen, a Connecticuti Egyetem adjunktusa szintén kifogásolta, hogy a levélben megemlítik a munkáját. Tavaly társszerzője volt egy kutatásnak, amelyben azt állította, hogy a mesterséges intelligencia széles körű alkalmazása már most is komoly kockázatokat rejt magában.

Kutatása szerint a MI-rendszerek mai használata befolyásolhatja a döntéshozatalt az éghajlatváltozással, a nukleáris háborúval és más egzisztenciális fenyegetésekkel kapcsolatban.

Ezt a Reutersnek nyilatkozta: „A mesterséges intelligenciának nem kell elérnie az emberi szintű intelligenciát ahhoz, hogy súlyosbítsa ezeket a kockázatokat. Azonban vannak nem egzisztenciális kockázatok is, amelyek nagyon-nagyon fontosak, de nem kapnak ugyanolyan hollywoodi szintű figyelmet”.

Az FLI elnökét, Max Tegmarkot felkérték, hogy kommentálja a kritikát. A szakember azt nyilatkozta, hogy a mesterséges intelligencia rövid és hosszú távú kockázatait egyaránt komolyan kell venni. „Ha idézünk valakit, az csak azt jelenti, hogy azt állítjuk, az illető támogatja azt a gondolatot. De nem jelenti azt, hogy az idézett személyek támogatják a levelet, vagy hogy mi támogatunk mindent, amit gondolnak” – mondta a Reutersnek.

Rád is szükségünk van!

A Transtelex minden nap hiteles, ellenőrzött erdélyi történeteket hoz — sokszor több munkával, több kérdéssel és több utánajárással, mint mások. Ha fontos neked, hogy legyen független forrás, ahol a kényelmetlen kérdéseket is felteszik, kérjük, támogasd a munkánkat!

Támogatás